CryptoWorldFuligong

CryptoWorldFuligong

現在、コンテンツはありません

- 報酬

- いいね

- コメント

- 共有

孫哥は本当に面白いことをする、偽のアカウントを見たかと思った。@sunyuchentron

原文表示- 報酬

- いいね

- コメント

- 共有

リン姓の人は苦しい運命の人が多いことに気づいているかどうかわからない。

林冲、林黛玉、林平之、あなたは古代の林姓の人々だけが不幸だと思いますか?

現代:リン・ピンルー、親友に裏切られ、夫に家から追い出される。

林姓と同じくらい運が悪いのは、韭菜だけだ。弱気市場のとき、持っている草コインが損をして、やっと牛市を迎えたが、結果として草コインがさらにひどく損をした。。。

最終的には海に行くしかない @KaitoAI 、結果的に毎日得点が上がらない。

原文表示林冲、林黛玉、林平之、あなたは古代の林姓の人々だけが不幸だと思いますか?

現代:リン・ピンルー、親友に裏切られ、夫に家から追い出される。

林姓と同じくらい運が悪いのは、韭菜だけだ。弱気市場のとき、持っている草コインが損をして、やっと牛市を迎えたが、結果として草コインがさらにひどく損をした。。。

最終的には海に行くしかない @KaitoAI 、結果的に毎日得点が上がらない。

- 報酬

- いいね

- コメント

- 共有

時々、AIが間違ったことを言うのは、それが愚かだからではなく、誰もそれに責任を持つように求めていないからです。

私は多くの「AIツール」を使ったことがあります。書くのは速く、絵はそれなりに描けますが、毎回それが真面目にデータを作り、論理をめちゃくちゃに語っているのを見ると、私は一つのことを理解します:生成は問題ではなく、検証が門戸です。

これが私が@Mira_Networkに関心を持っている理由です。

それは次のChatGPTを作ろうとしているのではなく、一連のGPUを使って推論コンペを行おうとしているのでもありません。むしろ、AIの出力をどう信頼できるのかという質問を異なる視点から直接投げかけています。

ミラが与えた答えは「私たちはもっと強いモデルを持っている」ではなく、「AIに話をさせたければ、それが調べられ、責任を問われ、証明される必要がある」でした。

あなたはMiraエコシステムでAIを使ってコンテンツを生成します。それは一連の小さな判断に分解され、複数のノードに検証を依頼します。このプロセスはブロックチェーンに記録され、結果が合意され、エラーが発生した場合は賠償が必要です。

あなたはそれを使って文章を書いたり、定義を検索したり、画像を生成したりできます。その横には、この結論が誰によって提供されたのか、合意があるのか、信頼できるのかが示されます。

以前AIを使っていた時は、

原文表示私は多くの「AIツール」を使ったことがあります。書くのは速く、絵はそれなりに描けますが、毎回それが真面目にデータを作り、論理をめちゃくちゃに語っているのを見ると、私は一つのことを理解します:生成は問題ではなく、検証が門戸です。

これが私が@Mira_Networkに関心を持っている理由です。

それは次のChatGPTを作ろうとしているのではなく、一連のGPUを使って推論コンペを行おうとしているのでもありません。むしろ、AIの出力をどう信頼できるのかという質問を異なる視点から直接投げかけています。

ミラが与えた答えは「私たちはもっと強いモデルを持っている」ではなく、「AIに話をさせたければ、それが調べられ、責任を問われ、証明される必要がある」でした。

あなたはMiraエコシステムでAIを使ってコンテンツを生成します。それは一連の小さな判断に分解され、複数のノードに検証を依頼します。このプロセスはブロックチェーンに記録され、結果が合意され、エラーが発生した場合は賠償が必要です。

あなたはそれを使って文章を書いたり、定義を検索したり、画像を生成したりできます。その横には、この結論が誰によって提供されたのか、合意があるのか、信頼できるのかが示されます。

以前AIを使っていた時は、

- 報酬

- いいね

- コメント

- 共有

面白いことが一つ...

昨晩、夢を見ました。自分がNFTを発行して、「カラスの水飲み」という名前を付けました。

ミントした後、カラスは最初は灰色です。あなたは毎日瓶に小石を入れる必要があります。水が瓶の口まで上がるまで、カラスが水を飲むと画像はカラフルに変わります。

小石子はカラスが水を飲むためのトークン:カラスコインです。カラスが水を飲む前に、NFTは上場取引できません。

カラスに希少属性を与えるために、異なる色の瓶をデザインしました。例えば、ガラス瓶は1個の石で水を飲むことができます;酒瓶、ジュース瓶、香水瓶、調味料瓶はそれぞれ2、3、4、5個の石を必要とします;最も希少な茅台瓶とラフィ瓶は、9個と10個の石が必要です。

毎日一つの石を与えることができ、一つの石は1つのカラスコインに相当します。

カラスNFTの背景はDIY可能で、@KaitoAIの広告主はロゴを入れることができ、収入は各NFT保有者に帰属します。

このNFTは発売されるやいなや大人気となり、売り圧力を解消し、NFTの長期的な実地の難しさをも解決しました。

クリエイターとして、毎日のお金は水のようにざあざあ流れ込んできます。喜んでいると、3歳の息子が私をおしっこで起こしました...

原文表示昨晩、夢を見ました。自分がNFTを発行して、「カラスの水飲み」という名前を付けました。

ミントした後、カラスは最初は灰色です。あなたは毎日瓶に小石を入れる必要があります。水が瓶の口まで上がるまで、カラスが水を飲むと画像はカラフルに変わります。

小石子はカラスが水を飲むためのトークン:カラスコインです。カラスが水を飲む前に、NFTは上場取引できません。

カラスに希少属性を与えるために、異なる色の瓶をデザインしました。例えば、ガラス瓶は1個の石で水を飲むことができます;酒瓶、ジュース瓶、香水瓶、調味料瓶はそれぞれ2、3、4、5個の石を必要とします;最も希少な茅台瓶とラフィ瓶は、9個と10個の石が必要です。

毎日一つの石を与えることができ、一つの石は1つのカラスコインに相当します。

カラスNFTの背景はDIY可能で、@KaitoAIの広告主はロゴを入れることができ、収入は各NFT保有者に帰属します。

このNFTは発売されるやいなや大人気となり、売り圧力を解消し、NFTの長期的な実地の難しさをも解決しました。

クリエイターとして、毎日のお金は水のようにざあざあ流れ込んできます。喜んでいると、3歳の息子が私をおしっこで起こしました...

- 報酬

- いいね

- コメント

- 共有

テストコード @anoma 一码難求、場外80-100ドルになりました。

anomaはなぜこんなに人気なのか?

それのテストネットは、従来の「ボタンをクリックして、取引を行う」というプロセスではなく、インタラクションを可視化された「世界」として直接作成しています。

キャラクターの移動を制御したり、タスクをトリガーしたりすることができます。初期のオンチェーンゲームに似ていますが、論理は明らかに一層深いです。

最も直感的な感覚は、"操作を行う"のではなく、"あなたが何を望んでいるかを表現する"ことから始まり、システムがそれを達成する方法を考えるということです。

これが Anoma が言う「意図駆動アーキテクチャ」です。

テストネットの入口はこちら:

ページに入るには招待コードが必要です。Discordで少し待っていればほとんど手に入ります。

現在オンラインのタスクは多くありませんが、ゲームプレイのフレームワークから彼らがこのシステムをどう構築したいかが見えてきます。

例えば、地図上のその Fitcoin ポイントでチェックインすると、テストコインを受け取ることができます。他のいくつかのエリアでも、いくつかの簡単な機能をアンロックすることができます。

Anomaの公式Twitterの最近の更新、エコシステムはすでに始動しています:

チームがそれを使ってAIエージェントを作成しているも

anomaはなぜこんなに人気なのか?

それのテストネットは、従来の「ボタンをクリックして、取引を行う」というプロセスではなく、インタラクションを可視化された「世界」として直接作成しています。

キャラクターの移動を制御したり、タスクをトリガーしたりすることができます。初期のオンチェーンゲームに似ていますが、論理は明らかに一層深いです。

最も直感的な感覚は、"操作を行う"のではなく、"あなたが何を望んでいるかを表現する"ことから始まり、システムがそれを達成する方法を考えるということです。

これが Anoma が言う「意図駆動アーキテクチャ」です。

テストネットの入口はこちら:

ページに入るには招待コードが必要です。Discordで少し待っていればほとんど手に入ります。

現在オンラインのタスクは多くありませんが、ゲームプレイのフレームワークから彼らがこのシステムをどう構築したいかが見えてきます。

例えば、地図上のその Fitcoin ポイントでチェックインすると、テストコインを受け取ることができます。他のいくつかのエリアでも、いくつかの簡単な機能をアンロックすることができます。

Anomaの公式Twitterの最近の更新、エコシステムはすでに始動しています:

チームがそれを使ってAIエージェントを作成しているも

AGENT-5.04%

- 報酬

- いいね

- コメント

- 共有

カウントダウン6日、@Infinit_Labs シーズン1がもうすぐ終了します。

TGEはまだ第2シーズンを開く予定がありますか?

現在のプロジェクト側は明言していませんが、インセンティブメカニズムとリズムから見ると、第2シーズンを開く確率は低くありません。

$INの用途について、現在確認されているいくつかのポイントは次のとおりです:

→ ステーキング分配:戦略実行やスマートエージェント操作の手数料の一部がステーキング者に分配され、プラットフォームの収益の一部がコミュニティに帰属します。

→ アンロック機能:一部の高度な戦略実行権、手数料割引、戦略生成ツール優先使用権は、$INをステーキングする必要があります。

→ クリエイターインセンティブ:将来的にコミュニティ戦略が増えるほど、アクティブなユーザーとクリエイターがより重視され、$INはこの循環に入るための「チケット」です。

全体的に見ると、$INは単なるガバナンストークンではなく、DeFiスマート戦略プラットフォームの機能証明書と利益配当のようなものです。

もしまだ @KaitoAI に参加していないなら、エアドロップ第1シーズンはあと6日です。時間がありません。

TGEはまだ第2シーズンを開く予定がありますか?

現在のプロジェクト側は明言していませんが、インセンティブメカニズムとリズムから見ると、第2シーズンを開く確率は低くありません。

$INの用途について、現在確認されているいくつかのポイントは次のとおりです:

→ ステーキング分配:戦略実行やスマートエージェント操作の手数料の一部がステーキング者に分配され、プラットフォームの収益の一部がコミュニティに帰属します。

→ アンロック機能:一部の高度な戦略実行権、手数料割引、戦略生成ツール優先使用権は、$INをステーキングする必要があります。

→ クリエイターインセンティブ:将来的にコミュニティ戦略が増えるほど、アクティブなユーザーとクリエイターがより重視され、$INはこの循環に入るための「チケット」です。

全体的に見ると、$INは単なるガバナンストークンではなく、DeFiスマート戦略プラットフォームの機能証明書と利益配当のようなものです。

もしまだ @KaitoAI に参加していないなら、エアドロップ第1シーズンはあと6日です。時間がありません。

DEFI-4.58%

- 報酬

- いいね

- コメント

- 共有

あなたはアリムを知らないかもしれませんが、「背景があまりにも偽っぽい」という動画は見たことがあるでしょう。

最近、彼の人設が崩れ、エンジェル投資家と法廷で対峙しています。相手は70万を出資して彼の起業を助けましたが、彼は自分と妻がそれぞれ30%の株を占めるように仕組み、大株主を会社から追い出しました。

現在、アリムは会社を解散し、店舗のすべてのものも撤去されました。

この件について、私自身の体験から言うと、アリムは勝つことは不可能です。私自身が起業したばかりの頃、友人たちと一緒にマイニングをしていて、その時はお金がほとんどありませんでした。

大きな兄貴が資金を提供して大株主になり、40%の株式を独占しています。私たち三人はそれぞれ20%を占めています。大株主は何もしなくても良く、時々来てマイニングマシンの運用状況をチェックするだけです。

私たちのような少数株主は朝から晩まで働いていて、大株主に文句を言われるのがとても恐ろしいです。大株主が来るたびに、私たちは慎重に接しています。

私の記憶では、大株主は一つの仕事をしました。ある日の午後、彼は自分で羊肉串が食べたくなり、自ら串を焼いて、皆を少しご馳走しました。その時、私は地方で仕事をしていて、結局食べることができませんでした。

なぜなら、私は大株主が働く必要がないと述べるのは、アリムがビデオの中で大株主が普段オフロードを好み、会社の事

原文表示最近、彼の人設が崩れ、エンジェル投資家と法廷で対峙しています。相手は70万を出資して彼の起業を助けましたが、彼は自分と妻がそれぞれ30%の株を占めるように仕組み、大株主を会社から追い出しました。

現在、アリムは会社を解散し、店舗のすべてのものも撤去されました。

この件について、私自身の体験から言うと、アリムは勝つことは不可能です。私自身が起業したばかりの頃、友人たちと一緒にマイニングをしていて、その時はお金がほとんどありませんでした。

大きな兄貴が資金を提供して大株主になり、40%の株式を独占しています。私たち三人はそれぞれ20%を占めています。大株主は何もしなくても良く、時々来てマイニングマシンの運用状況をチェックするだけです。

私たちのような少数株主は朝から晩まで働いていて、大株主に文句を言われるのがとても恐ろしいです。大株主が来るたびに、私たちは慎重に接しています。

私の記憶では、大株主は一つの仕事をしました。ある日の午後、彼は自分で羊肉串が食べたくなり、自ら串を焼いて、皆を少しご馳走しました。その時、私は地方で仕事をしていて、結局食べることができませんでした。

なぜなら、私は大株主が働く必要がないと述べるのは、アリムがビデオの中で大株主が普段オフロードを好み、会社の事

- 報酬

- いいね

- コメント

- 共有

好きな五月天がもう10年近くなりました。彼らは本当に不老の男神ですね。

私はもう年を取ったが、彼らは昔と変わらず若いままだ。

子供の頃、母が買ってくれた歩歩高の点読機を使って、ひそかに彼らの歌をダウンロードしたことを覚えています。

ある時、私はヘッドフォンで五月天を聴いていたときに、うっかり声を出してしまい、母に見つかってヘッドフォンを奪われました。

私はすぐに涙が溢れ出て、母に怒って言った。「あなたは私のプライバシーを侵害した。」

プライバシーについて言えば、多くのL1は「スケーラビリティ」と「低いハードル」を競っていますが、みんながあまり触れたがらない問題があります——プライバシー。

@burnt_xion この問題を「基盤設計」として直接扱うべきであり、パッチではなく、主なロジックです:

「あなたの財布を守る」ではなく、あなたが財布を全く気にしなくて済むようにする。

Metaアカウントから、選択的開示(セレクティブディスクロージャー)、そしてLit Protocolの暗号ストレージの統合に至るまで、XIONは「プライバシー+」を追求するのではなく、「アイデンティティ-信頼-データ」のオンチェーンのクローズドループを再構築しています:

あなたは秘密鍵を気にする必要はありません、抽象化してください

あなたの取引プロセスは公開されず、ZKが処理します

あなたがアップロードしたデータ

原文表示私はもう年を取ったが、彼らは昔と変わらず若いままだ。

子供の頃、母が買ってくれた歩歩高の点読機を使って、ひそかに彼らの歌をダウンロードしたことを覚えています。

ある時、私はヘッドフォンで五月天を聴いていたときに、うっかり声を出してしまい、母に見つかってヘッドフォンを奪われました。

私はすぐに涙が溢れ出て、母に怒って言った。「あなたは私のプライバシーを侵害した。」

プライバシーについて言えば、多くのL1は「スケーラビリティ」と「低いハードル」を競っていますが、みんながあまり触れたがらない問題があります——プライバシー。

@burnt_xion この問題を「基盤設計」として直接扱うべきであり、パッチではなく、主なロジックです:

「あなたの財布を守る」ではなく、あなたが財布を全く気にしなくて済むようにする。

Metaアカウントから、選択的開示(セレクティブディスクロージャー)、そしてLit Protocolの暗号ストレージの統合に至るまで、XIONは「プライバシー+」を追求するのではなく、「アイデンティティ-信頼-データ」のオンチェーンのクローズドループを再構築しています:

あなたは秘密鍵を気にする必要はありません、抽象化してください

あなたの取引プロセスは公開されず、ZKが処理します

あなたがアップロードしたデータ

- 報酬

- いいね

- コメント

- 共有

ハイペリオンは最近、Aptosでのパフォーマンスがますます安定しています。

最初のCLMMモデルから始まり、現在はオーダーブックの立ち上げに向けて準備を進め、RIONのインセンティブとエコシステムの連携を経て、取引体験を本当に向上させるための道を歩んでいます。単なるリブランドのクイックフラッシュDEXではありません。

なぜ @Aptos でこんなにスムーズに動くのか?鍵はやはり基盤の性能が優れているからだ。

Aptosの並行処理とMove言語の安全性により、Hyperionのような二重モデルDEXは高頻度取引ロジックを支え、チェーンの切断やダウンタイムなしで、複雑な製品を作るためのスペースを提供します。振り返ってみると、たとえオンチェーンオーダーブックのようなパフォーマンスを消費する設計でも、Aptos上で試すことができるのです。

また、Hyperionは「新しいモデル」だけで利益を得ているわけではなく、TVLと流動性が実際に増加しており、エコシステムプロジェクトも次々と接続されています。前にはRIONのエアドロップがあり、後にはCattos、Shelby、Funtasyといった後続のコンボが続いており、リズムが一環としてつながっています。

Aptosにはコンセプトプロジェクトが不足しているわけではなく、Hyperionのように真剣に製品を構築し、かつブロックチェーン上で複雑なメカ

原文表示最初のCLMMモデルから始まり、現在はオーダーブックの立ち上げに向けて準備を進め、RIONのインセンティブとエコシステムの連携を経て、取引体験を本当に向上させるための道を歩んでいます。単なるリブランドのクイックフラッシュDEXではありません。

なぜ @Aptos でこんなにスムーズに動くのか?鍵はやはり基盤の性能が優れているからだ。

Aptosの並行処理とMove言語の安全性により、Hyperionのような二重モデルDEXは高頻度取引ロジックを支え、チェーンの切断やダウンタイムなしで、複雑な製品を作るためのスペースを提供します。振り返ってみると、たとえオンチェーンオーダーブックのようなパフォーマンスを消費する設計でも、Aptos上で試すことができるのです。

また、Hyperionは「新しいモデル」だけで利益を得ているわけではなく、TVLと流動性が実際に増加しており、エコシステムプロジェクトも次々と接続されています。前にはRIONのエアドロップがあり、後にはCattos、Shelby、Funtasyといった後続のコンボが続いており、リズムが一環としてつながっています。

Aptosにはコンセプトプロジェクトが不足しているわけではなく、Hyperionのように真剣に製品を構築し、かつブロックチェーン上で複雑なメカ

- 報酬

- いいね

- コメント

- 共有

男の聖なる三位一体△定律:イケメン、お金持ち、一途。

女性の聖なる三位一体△定律:優しさ、賢さ、美しさ。

彼女の聖なる三位一体△定律:胸が大きく、脚が長く、美しい。

プロジェクトの聖なる三位一体△の法則:ビジョン、実力、コミュニティ。

原文表示女性の聖なる三位一体△定律:優しさ、賢さ、美しさ。

彼女の聖なる三位一体△定律:胸が大きく、脚が長く、美しい。

プロジェクトの聖なる三位一体△の法則:ビジョン、実力、コミュニティ。

- 報酬

- いいね

- コメント

- 共有

$Melis ちょっとやった

0x7df4a60d0144859bff73dcb2663ae74df8dc4444

原文表示0x7df4a60d0144859bff73dcb2663ae74df8dc4444

- 報酬

- いいね

- コメント

- 共有

以前はTwitterでアルファを探していましたが、今はライブ配信で探すことができます。外国では、@Soulbound_TVというライブ配信が人気です。

彼らは StreamFi を運営しており、$SBX を使用して「ライブコンテンツ」をブロックチェーン上の資産に変え、視聴者はインタラクション、ベッティング、チップを行うことができ、配信者の収入はリアルタイムで入金されます。

より実用的で、Twitchよりも公平な市場に近いです。

原文表示彼らは StreamFi を運営しており、$SBX を使用して「ライブコンテンツ」をブロックチェーン上の資産に変え、視聴者はインタラクション、ベッティング、チップを行うことができ、配信者の収入はリアルタイムで入金されます。

より実用的で、Twitchよりも公平な市場に近いです。

- 報酬

- いいね

- コメント

- 共有

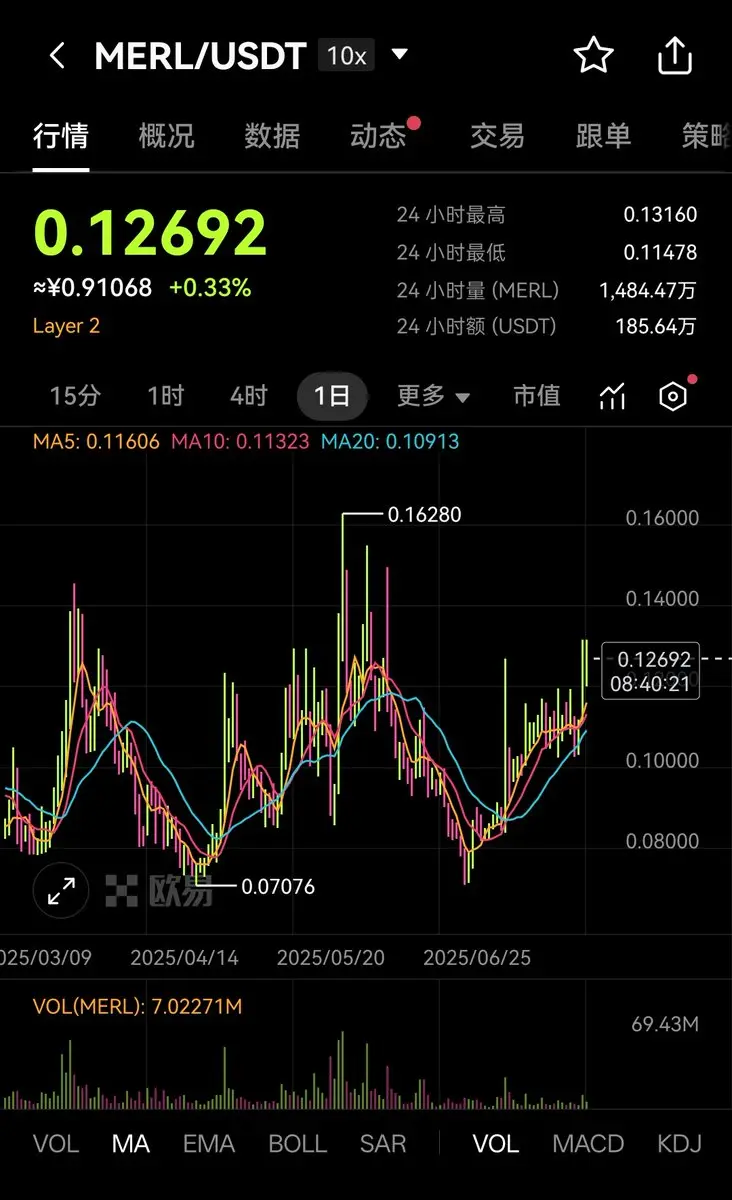

多くの人がある通貨が静かに力を入れていることを見落としており、ロングしている人はすでに大きな利益を上げています。それは $MERL です。

過去一年、BTCfiは疑問視されるところから再定義され、Merlinはずっとその場にいました。

当初 Merlin 横空出世、質権でビットコインを充血させ、今回 BTCfi が夢を現実にし、非常に強い生命力を示しました。

最初にBTCfiのナラティブを推進したプロジェクトの一つとして、Merlinの進化の道筋は明確である:

初期のBTCステーキングから、現在の2.0ロードマップでは3つの主要なラインが明確になっています——BTC保有による利益、BTCクロスチェーンによるホット資産への参加、最終的な資金のBTCへの回帰が形成され、クローズドループが実現しています。これは単一の機能の最適化ではなく、BTCを中心とした資産利用システム全体を構築しているのです。

現在 $MERL の時価総額は1億に満たず、調整は十分で、ボトム構造が現れ、物語は「BTCの実際の使用シーン」に再び焦点を合わせ始めています。ほとんどがPPT段階にあるBTCfiプロジェクトと比較して、Merlinは完全な製品と実際に運営されているエコプロジェクト(Solv、Bedrock、Babylonなど)を持っています。

取引の観点から見ると、最近 MERL は $0.126 を突破し、

原文表示過去一年、BTCfiは疑問視されるところから再定義され、Merlinはずっとその場にいました。

当初 Merlin 横空出世、質権でビットコインを充血させ、今回 BTCfi が夢を現実にし、非常に強い生命力を示しました。

最初にBTCfiのナラティブを推進したプロジェクトの一つとして、Merlinの進化の道筋は明確である:

初期のBTCステーキングから、現在の2.0ロードマップでは3つの主要なラインが明確になっています——BTC保有による利益、BTCクロスチェーンによるホット資産への参加、最終的な資金のBTCへの回帰が形成され、クローズドループが実現しています。これは単一の機能の最適化ではなく、BTCを中心とした資産利用システム全体を構築しているのです。

現在 $MERL の時価総額は1億に満たず、調整は十分で、ボトム構造が現れ、物語は「BTCの実際の使用シーン」に再び焦点を合わせ始めています。ほとんどがPPT段階にあるBTCfiプロジェクトと比較して、Merlinは完全な製品と実際に運営されているエコプロジェクト(Solv、Bedrock、Babylonなど)を持っています。

取引の観点から見ると、最近 MERL は $0.126 を突破し、

- 報酬

- いいね

- 1

- 共有

TonightWeAreGoingToCatch :

:

人を騙さないで、ポンプ上昇が王道で、他は無駄話だ?- 報酬

- いいね

- コメント

- 共有

- 報酬

- いいね

- コメント

- 共有

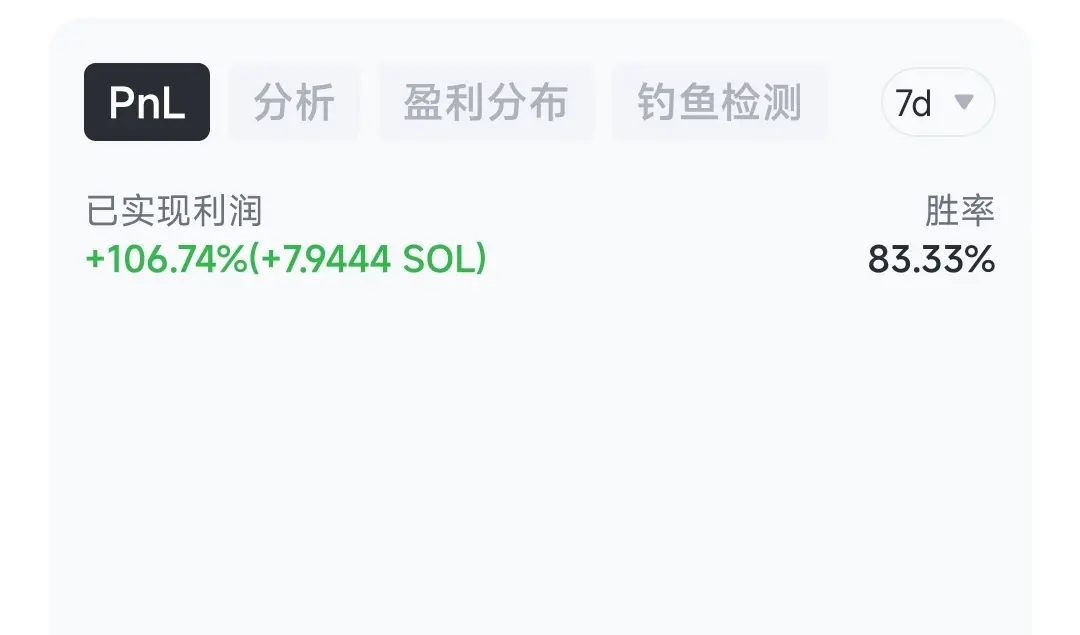

昨日、市場が来ていることに気づき、多くの人がCTOを始めました。それで、GMGNを使って七八個のミームトークンを購入しましたが、大多数が上昇しました。これは初心者保護期間ですか?

原文表示

- 報酬

- いいね

- コメント

- 共有